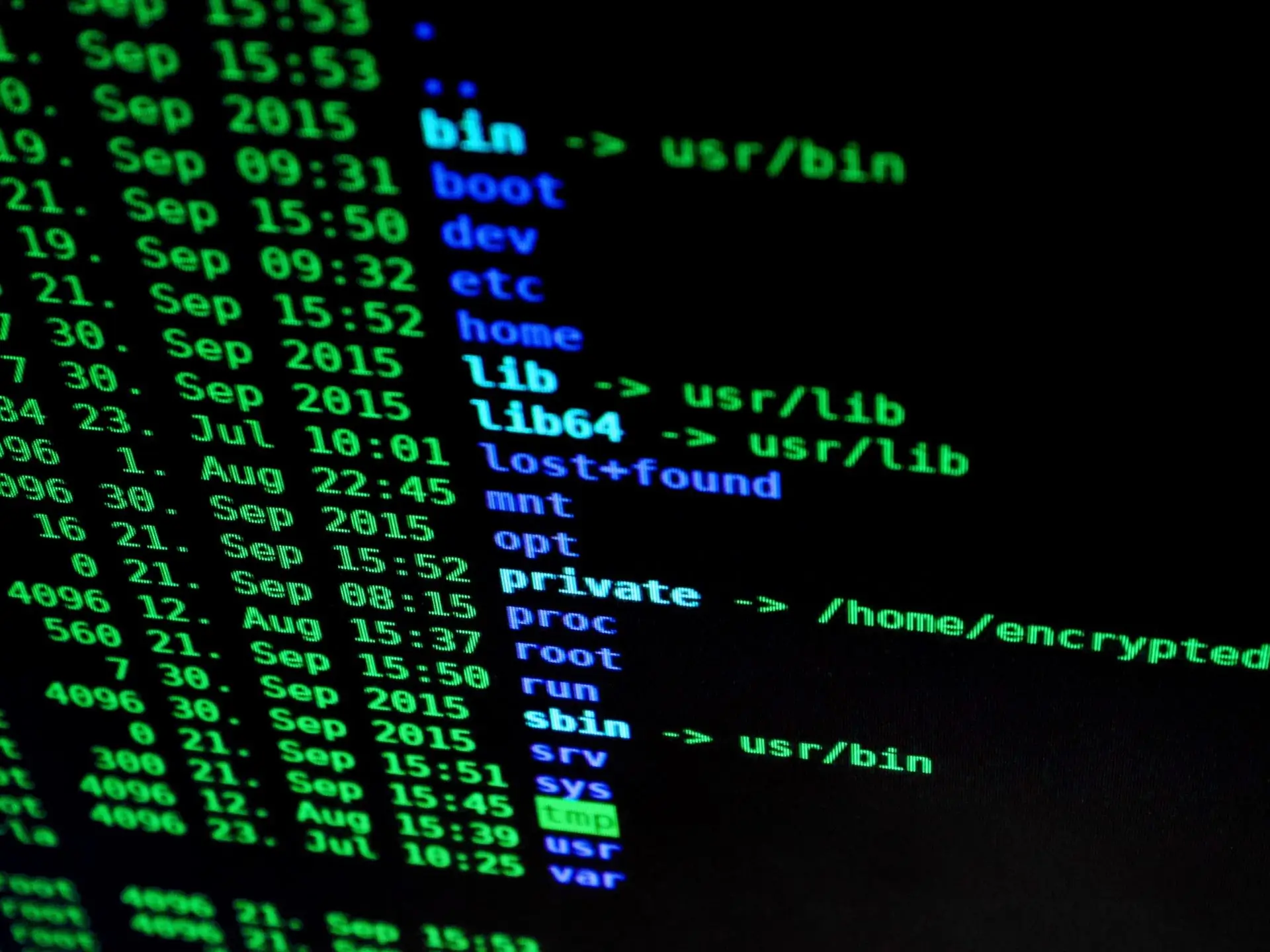

Le Cloaking (signifiant dissimulation en français) est une technique utilisée pour rendre des pages Web les plus visibles possibles et augmenter ainsi la visibilité du site auxquelles elles appartiennent. Grâce au cloaking, deux Internautes qui tapent le même mot-clé dans la barre de recherche pourront atterrir sur des pages complètement différentes et avoir des résultats qui n’ont rien à voir. Les spiders, les robots des moteurs de recherche, et les utilisateurs obtiennent deux versions différentes s’il s’agit d’une page Web dite « cloakée ».

Le cloaking peut être sciemment utilisé de manière malhonnête par des utilisateurs et être considéré comme un spam par les moteurs de recherche. D’ailleurs, Google sanctionne les cloakers mal intentionnés dont les actions nuisent à leurs concurrents. Il est indispensable de bien comprendre tous les enjeux du cloaking, notamment ses avantages et ses inconvénients, ses différentes formes et enfin, les différentes techniques de cloaking.